总体来说,Baiduspider会根据站点规模、历史上网站每天新产出的链接数量、已抓取网页的综合质量打分等等,来综合计算抓取流量,同时兼顾站长在抓取频次工具里设置的、网站可承受的最大抓取值。

从目前追查过的抓取流量突增的case中,原因可以分为以下几种:

1, Baiduspider发现站内JS代码较多,调用大量资源针对JS代码进行解析抓取

2, 百度其他部门(如商业、图片等)的spider在抓取,但流量没有控制好

3, 已抓取的链接,打分不够好,垃圾过多,导致spider重新抓取

4, 站点被攻击,有人仿冒百度爬虫(见下文关于BaiduSpider)

如果站长排除了自身问题、仿冒问题,确认BaiduSpider抓取流量过大的话,可以通过百度的反馈中心(http://zhanzhang.baidu.com/feedback)反馈,注:一定要提供详细的抓取日志截图。

关于BaiduSpider

如何正确识别Baiduspider移动ua

新版移动ua:

Mozilla/5.0 (Linux;u;Android4.2.2;zh-cn;)

AppleWebKit/534.46 (KHTML,like Gecko)

Version/5.1 Mobile Safari/10600.6.3 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

PC ua:Mozilla/5.0(compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)之前通过“+http://www.baidu.com/search/spider.html”进行识别的网站请注意!需要修改识别方式,新的正确的识别Baiduspider移动ua的方法如下:

1. 通过关键词“Android”或者“Mobile”来进行识别,判断为移动访问或者抓取。

2. 通过关键词“Baiduspider/2.0”,判断为百度爬虫。

另外需要强调的是,对于robots封禁,如果封禁的agent是Baiduspider,会对PC和移动同时生效。即,无论是PC还是移动Baiduspider,都不会对封禁对象进行抓取。之所以要强调这一点,是发现有些代码适配站点(同一个url,PC ua打开的时候是PC页,移动ua打开的时候是移动页),想通过设置robots的agent封禁达到只让移动Baiduspider抓取的目的,但由于PC和移动Baiduspider的agent都是Baiduspider,这种方法是非常不可取的。

如何识别百度蜘蛛

百度蜘蛛对于站长来说可谓上宾,可是也有站长会发出这样的疑问:

我们如何判断疯狂抓我们网站内容的蜘蛛是不是百度的?

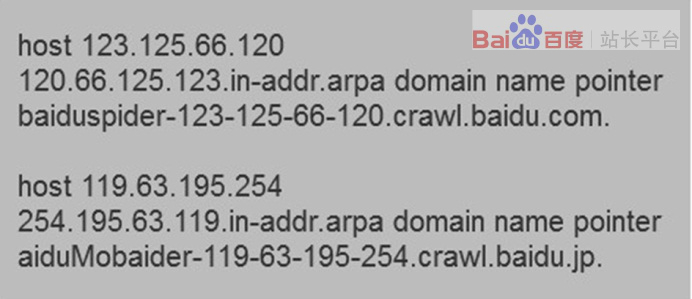

其实站长可以通过DNS反查IP的方式判断某只spider是否来自百度搜索引擎。根据平台不同验证方法不同,如linux/windows/os三种平台下的验证方法分别如下:

1、在linux平台下,可以使用hostip命令反解ip来判断是否来自Baiduspider的抓取。Baiduspider的hostname以*.baidu.com或*.baidu.jp的格式命名,非*.baidu.com或*.baidu.jp即为冒充。

2、在windows平台或者IBMOS/2平台下,可以使用nslookupip命令反解ip来判断是否来自Baiduspider的抓取。打开命令处理器输入nslookupxxx.xxx.xxx.xxx(IP地址)就能解析ip,来判断是否来自Baiduspider的抓取,Baiduspider的hostname以*.baidu.com或*.baidu.jp的格式命名,非*.baidu.com或*.baidu.jp即为冒充。

3、在macos平台下,您可以使用dig命令反解ip来判断是否来自Baiduspider的抓取。打开命令处理器输入digxxx.xxx.xxx.xxx(IP地址)就能解析ip,来判断是否来自Baiduspider的抓取,Baiduspider的hostname以*.baidu.com或*.baidu.jp的格式命名,非*.baidu.com或*.baidu.jp即为冒充。

Baiduspider IP是多少

即便很多站长知道了如何判断百度蜘蛛,仍然会不断地问“百度蜘蛛IP是多少”。并想将百度蜘蛛所在IP加入白名单,只准白名单下IP对网站进行抓取,避免被采集等行为。

百度方面表示,不建议站长这样做。虽然百度蜘蛛的确有一个IP池,真实IP在这个IP池内切换,但无法保证这个IP池整体不会发生变化。所以,建议站长勤看日志,发现恶意蜘蛛后放入黑名单,以保证百度的正常抓取。

同时,百度方面还强调:通过IP来分辨百度蜘蛛的属性是非常可笑的事情,所谓的“沙盒蜘蛛”“降权蜘蛛”等等是从来都不存在的。

阅读量能达到300W的推文,到底都写了些什么?文章来源:西瓜君(公众号ID:抢新闻,重时效“速度是新闻的第一生命力”对于资讯类地方号来说,内容能够在短时间内引起关注和传播,时效是一个很关键的因素。如果能够在

阅读量能达到300W的推文,到底都写了些什么?文章来源:西瓜君(公众号ID:抢新闻,重时效“速度是新闻的第一生命力”对于资讯类地方号来说,内容能够在短时间内引起关注和传播,时效是一个很关键的因素。如果能够在 不是土豪,也能借势欧洲杯?根据统计,上一届欧洲杯期间,每场比赛高达0.77的收视率,仅次于奥运会,远超其余电视节目。有62.2%的网民明确表示会关注欧洲杯相关话题。面对如此火爆的周期性体

不是土豪,也能借势欧洲杯?根据统计,上一届欧洲杯期间,每场比赛高达0.77的收视率,仅次于奥运会,远超其余电视节目。有62.2%的网民明确表示会关注欧洲杯相关话题。面对如此火爆的周期性体 最新论坛运营推广实战案例+详解方法(2.8万的课)论坛推广难吗一、如何高效的做论坛推广(方法)?1、抢沙发这种很俗的的抢沙发对于操作过论坛推广的朋友应该是非常熟悉不过了,但是,抢沙发主要分为两种,一种是手工抢沙

最新论坛运营推广实战案例+详解方法(2.8万的课)论坛推广难吗一、如何高效的做论坛推广(方法)?1、抢沙发这种很俗的的抢沙发对于操作过论坛推广的朋友应该是非常熟悉不过了,但是,抢沙发主要分为两种,一种是手工抢沙